Data-Mining – DatenanalyseWas ist Data-Mining?

Mit Data-Mining nach Wertvollem im Datenberg und Datenstrom suchen

Neue und unbekannte Themen werden häufig mit Analogien beschrieben, um Zusammenhänge zu verdeutlichen und Dinge anschaulich zu machen. Im Bereich der Datenanalyse wird gerne der Begriff „Data-Mining“ verwendet. Das erinnert an das Bild eines Goldsuchers, der in seiner Mine nach etwas Wertvollem buddelt. Und dieses Bild passt gut, wenn es um Data-Mining geht.

Data-Mining – Definition

Mit Data-Mining werden Massendaten oder umfangreiche Datensätze in Unternehmen analysiert und im Hinblick auf unternehmerische Fragestellungen ausgewertet. Beim Data-Mining werden dazu unterschiedliche statistische Methoden zur Aufbereitung, Darstellung und Analyse der Massendaten eingesetzt.

Das Data-Mining soll Besonderheiten, Muster, Zusammenhänge oder Wirkungsmechanismen im Unternehmen mit der Analyse der Daten aufdecken; im Englischen wird deshalb auch von Knowledge Discovery in Data (KDD) gesprochen.

Grundlage sind Daten, die an den unterschiedlichsten Stellen im Unternehmen entstehen können: durch Aktivitäten auf Webseiten, durch Transaktionen mit Kunden oder Ereignisse in der Organisation. Die Daten müssen nur in elektronischer Form (Logfiles, Datenbanken etc.) verfügbar sein.

Um beim Vergleich mit Goldgraben zu bleiben: Während des Goldrausches in Kalifornien suchten Menschen in engen Minen nach Goldadern oder durchsiebten Schlamm in den Flüssen nach Nuggets – das Gleiche geschieht beim Data-Mining mit Unternehmensdaten: Die Datenanalysten graben sich durch einen vorhandenen Datenbestand auf der Suche nach Gold oder sieben nach Nuggets im vorbeirauschenden Datenstrom. In diesem Zusammenhang passt auch das Zitat „Daten sind das Gold des 21. Jahrhunderts“ sehr gut.

Warum Data-Mining durchführen?

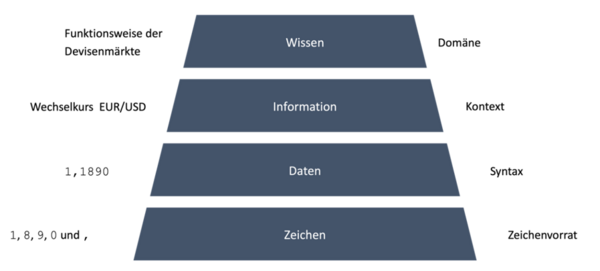

Doch was ist dieses Gold eigentlich genau, nach dem gesucht wird? Aus informationstheoretischer Sicht stehen Daten nur eine Stufe über den Zeichen und sagen noch nicht viel aus. Ein Beispiel für Daten wären die Zahlen 1,1893 oder 1,2154. Damit werden Sie noch nicht viel anfangen können.

Erst durch den Kontext, dass es sich hierbei um den Wechselkurs von Euro zu US-Dollar handelt, bekommen diese Daten eine Bedeutung. Einen tatsächlichen Wert haben die Informationen aber auch noch nicht. Erst mit dem zusätzlichen Wissen, ob es sich um günstige oder ungünstige Wechselkurse handelt, entstehen Informationen. Und erst mit diesen Informationen werden in Unternehmen Entscheidung vorbereitet oder getroffen.

Dieser Zusammenhang zwischen Zeichen, Daten, Informationen und Wissen ist in Abbildung 1 visualisiert:

- Daten bestehen aus Zeichen.

- Mit Kontext werden aus Daten Informationen.

- Und mit Wissen zur Domäne – dem Wissensgebiet, in dem die Informationen bedeutsam sind – werden daraus nützliche oder wertvolle Informationen (Gold).

Kompetenzen für Data-Mining

Wichtigstes Ziel von Data-Mining ist: Informationen zu generieren, mit denen ein Unternehmen Entscheidungen treffen kann. Daher sind für erfolgreiches Data-Mining Kompetenzen aus mehreren Bereichen notwendig: IT-Kompetenz, BWL-Kenntnisse, Mathematik und anwendungsspezifisches Fachwissen (sogenanntes Domänenwissen).

Da hier unterschiedliche wissenschaftliche Disziplinen vereint werden, spricht man in diesem Zusammenhang auch häufig von „Data Science“ oder seltener „Datenwissenschaft“. Je nach Komplexität der Analysen können diese Kompetenzen in einer Person vereint sein oder es kümmert sich ein ganzes Team aus Spezialisten der unterschiedlichen Disziplinen um ein größeres Projekt.

Manchmal werden die Kompetenzen auch in einer eigenen Organisationseinheit gebündelt, die häufig im Controlling oder Marketing angesiedelt ist.

Woraus der Wert einer Datenquelle entsteht

Genauso wie es in Kalifornien erfolgversprechende und aussichtslose Claims gab, gibt es in Unternehmen vielversprechende und öde Datentöpfe. Jedoch ist in diesem Zusammenhang nicht immer einfach zu identifizieren, was vielversprechend ist und was nicht. Je nachdem, welches Ziel mit Data-Mining und mit der damit verknüpften Entscheidung verfolgt wird, können unterschiedliche Datenquellen interessant sein.

Beispiel: Wenn Sie versuchen, Effizienzlücken in einem Produktionsprozess zu finden, werden Sie andere Datenquellen anzapfen, als wenn Sie versuchen, inaktive Kunden zum nächsten Einkauf zu bewegen.

Mit Data-Mining eine Übersicht über vorhandene Datenquellen schaffen

Daher ist es sehr wichtig, einen Überblick über die im Unternehmen vorhanden Datentöpfe zu haben und zu wissen, was wo gespeichert ist. In einer idealen Welt gibt es in einem Unternehmen einen zentralen Ort, an dem alle Daten gespeichert sind und der allen Mitarbeitenden Zugriff auf diese Daten gewährt.

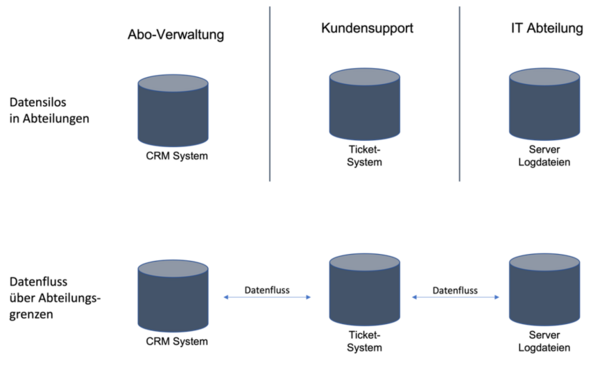

In der Praxis scheitert das jedoch bereits häufig an Abteilungsgrenzen oder technischen Inkompatibilitäten, die für Daten nicht durchlässig sind.

Es gibt unzählige Anwendungsprogramme und jedes arbeitet mit seinen eigenen Datentöpfen, wie es in Abbildung 2 veranschaulicht ist.

Datenquellen miteinander verbinden

Dabei können Sie durch Verbinden unterschiedlicher Datenquellen wertvolle Informationen generieren – Sie verknüpfen Ihre Daten und reichern sie mit zusätzlichen Informationen an. Erst durch diese Kombination werden unbekannte Zusammenhänge entdeckt, und Sie können unternehmerische Entscheidungen treffen oder auf entdeckte Sachverhalte reagieren.

Beispiel für Data-Mining: Kundenanalyse mithilfe von übergreifender Datenanalyse in einem Verlag

Daten aus der Kundenverwaltung

Stellen Sie sich einen Verlag vor, der die Verwaltung seiner Abos mit einem CRM-System (Customer-Relationship-Management) erledigt. Plötzlich erhöht sich die Kündigungsquote deutlich, was ein kritisches Signal ist. Die Gründe dafür müssen schnellstmöglich gefunden und beseitigt werden.

Die Kunden anzurufen und nach dem Kündigungsgrund zu fragen, würde sehr viel Zeit in Anspruch nehmen – und ob die Kunden wahrheitsgetreu Auskunft geben, ist dabei noch nicht einmal sicher. Daher versucht der Verlag mithilfe des Data-Minings, dem Problem auf den Grund zu gehen.

Daten aus dem Ticket-System im Kundensupport

Der Kundensupport des Verlags erfasst jedes Problem und jede Kundenbeschwerde in einem Ticket-System, sodass Fehlergründe und Fehlerhäufigkeiten gut analysiert werden können. Bei Analyse der gekündigten Abos aus dem CRM-System und den Beschwerden aus dem Ticket-System fällt auf, dass ein großer Teil der Kunden sich vor der Kündigung über Probleme in der App oder auf der Website beschwert hat. Der Verlag geht dieser Spur weiter nach und untersucht nun seine Website.

Daten aus den Log-Dateien der Webseiten

Die IT-Abteilung analysiert die Log-Dateien, in denen der Webserver alle Ereignisse protokolliert. Dabei fällt auf, dass auf der Verlagsseite ein Skript bei einem Update-Prozess beschädigt wurde. Dadurch haben sich die Ladezeiten deutlich verlängert und zum Teil brach sogar die Verbindung ab. Das Skript kann mit wenigen Handgriffen repariert werden und die Seite läuft danach wieder wie gewohnt.

Kombination der Datenquellen

Erst durch die Kombination unterschiedlicher Datenquellen, in diesem Fall das CRM-System, Ticket-System und Server-Logs, konnte der tatsächliche Grund für die Kündigungswelle gefunden werden. Außerdem hat der Verlag Informationen darüber gesammelt, wie seine Leserinnen und Leser auf Schwankungen der Website-Qualität reagieren.

Die Verantwortlichen im Verlag sind sich jetzt der Kundensensibilität bewusst. Für die Zukunft könnte die IT Sicherheitsmechanismen einrichten, die die Qualität der Seite laufend überwachen und im Notfall auf ein Backup-System umschalten können.

Die Frage, welche Informationsquellen im jeweiligen Fall tatsächlich benötigt und angezapft werden, ist von der Zielsetzung abhängig. Bei einer einzelnen Betrachtung des Ticket-Systems wären die Beschwerden über die Seite unter Umständen gar nicht aufgefallen, da sie nicht häufig genug waren, um aus der Masse herauszustechen. Erst durch die Verbindung von gekündigten Kunden und den Tickets ist der Zusammenhang aufgefallen.

Wenn Sie also im Unternehmen nach Datengold suchen, überlegen Sie sich vorher, welche Frage Sie beantworten möchten.

Datenbestand oder Datenstrom analysieren

Im vorherigen Beispiel hat das Unternehmen in seinem vorhandenen statischen Datenbestand gegraben, sozusagen in der Mine nach Gold geschürft. Es gibt jedoch noch eine zweite Möglichkeit, nach Gold zu suchen – im Fluss stehen und vorbeiströmendes Wasser und Schlamm nach Nuggets durchsieben. Auch diese Strategie kann auf Daten angewandt werden. Die Frage lautet demnach: Schürfen oder Sieben?

Der vorbeirauschende Datenfluss besteht oft aus Streaming- oder Transaktionsdaten, aus denen Informationen zum Zeitpunkt der Entstehung extrahiert werden. Ein häufiger Anwendungsfall ist die Betrugserkennung bei Kreditkartenzahlungen. Jeden Tag wickeln die großen Kreditkartenanbieter weltweit Milliarden von Zahlungen ab. Ein nachträgliches Analysieren in den vorhandenen Datenbeständen, welche Transaktion betrügerisch war, hilft in der Regel nichts. Die Betrüger sind entweder nicht mehr greifbar oder es ist sehr schwer, wieder an das Geld zu kommen.

Ein sinnvolles Betrugserkennungssystem muss also in dem Moment anschlagen, in dem die Zahlung durchgeführt oder angefragt wird. Dazu definieren die Kartenanbieter ein Regelwerk, das jede Transaktion in Echtzeit prüft und bei einem vermuteten Betrug die Zahlung ablehnt.

Eine einfache Regel basiert zum Beispiel auf Entfernungen und Transaktionszeitpunkten. Wird mit einer Kreditkarte um 13:00 in Hamburg in einem Geschäft bezahlt und um 13:15 wird versucht, in London Geld abzuheben, ist das offensichtlich nicht die gleiche Karte. Das System kann zwar nicht entscheiden, welche der beiden Transaktionen betrügerisch ist, aber es wird die zweite aus Sicherheitsgründen ablehnen.

Regeln der Datenanalyse festlegen

Damit diese Regeln und Algorithmen in Echtzeit auf vorbeirauschende Daten angewendet werden können, müssen sie zuerst definiert werden. Hierfür werden wieder herkömmliche Verfahren des Data-Minings angewendet. Das Kreditkarteninstitut hat nicht nur die gesamte Historie aller Transaktionen, sondern auch die Informationen, welche davon betrügerisch waren – zum Beispiel, weil Kunden den Betrug gemeldet haben.

Damit können auch komplexere Regeln als die obige definiert werden: Weicht eine Kreditkartenzahlung von dem bisherigen Verhalten des Kreditkarteninhabers ab, weil der Betrag ungewöhnlich hoch ist oder lange Zeit keine Umsätze getätigt wurden und auf einmal sehr viele, kann das auf Betrug hinweisen und das System schlägt Alarm.

An diesem Beispiel wird auch deutlich, dass die Regelerstellung und die Regelanwendung unterschiedliche Dynamiken haben. Das Ableiten der Regeln aus dem Datenberg muss nicht in Echtzeit passieren, das kann durchaus Stunden oder sogar Tage dauern. Wenn diese Regeln aber erst einmal definiert sind, können und müssen sie innerhalb kürzester Zeit im Datenstrom angewendet werden.

Risiken bei Data-Mining

Genauso wie im Goldrausch eine Infrastruktur aus Zuliefern, Händlern, Saloons und Hotels um die Goldsucher entstanden ist, gibt es auch ein eigenes Ökosystem um das Data-Mining. Es umfasst unter anderem spezielle Werkzeugkästen, die das Data-Mining möglichst einfach und unkompliziert ermöglichen sollen, spezialisierte Berater und optimierte Hardware für Datenanalysen.

Doch genauso wie damals gibt es auch heute viele Blender und Schurken, die „Katzengold“ oder wertlose Claims verkaufen oder anderweitig zu täuschen versuchen. Daher seien Sie an dieser Stelle gewarnt – es gibt keine Erfolgsgarantie beim Data-Mining! Auch wenn Sie ein Ziel klar definiert, saubere Daten und die passenden Werkzeuge haben und alles richtig einsetzen, kann es passieren, dass Sie nach vielen Stunden Analyse immer noch kein Ergebnis haben. Manchmal gibt es eben nichts zu entdecken.

Prüfen Sie für Ihr Unternehmen:

- Wo gibt es große Datenbestände oder Massendaten?

- Welche laufenden Aktionen oder Transaktionen gibt es in Ihrem Unternehmen, die analysiert werden könnten?

- Inwiefern werden diese Daten bereits ausgewertet?

Klären Sie in Bezug auf die vorhandenen Datenanalysen:

- Welche Ziele und Zwecke werden mit der Auswertung und Analyse dieser Daten verfolgt?

- Welche Fragen werden damit beantwortet?

- Für welche Entscheidungen sind diese Datenanalysen die Grundlage oder Voraussetzung?

Prüfen Sie dann, welche weitergehenden Fragen mit Data-Mining in Ihrem Unternehmen beantwortet werden könnten. Klären Sie dazu, inwiefern die für zukünftige Analysen und für die Antworten auf diese Fragen entsprechende Datenquellen bereits vorhanden sind.

Fassen Sie Ihre Überlegungen dazu zusammen und definieren Sie ein (erstes, mögliches) Data-Mining-Projekt.

Im nächsten Abschnitt erfahren Sie, mit welchen Methoden der deskriptiven Statistik Sie Ihre Datenquellen analysieren können und welche Kennzahlen dafür am besten geeignet sind.